来源:HIT专家网 作者:封诚 编译

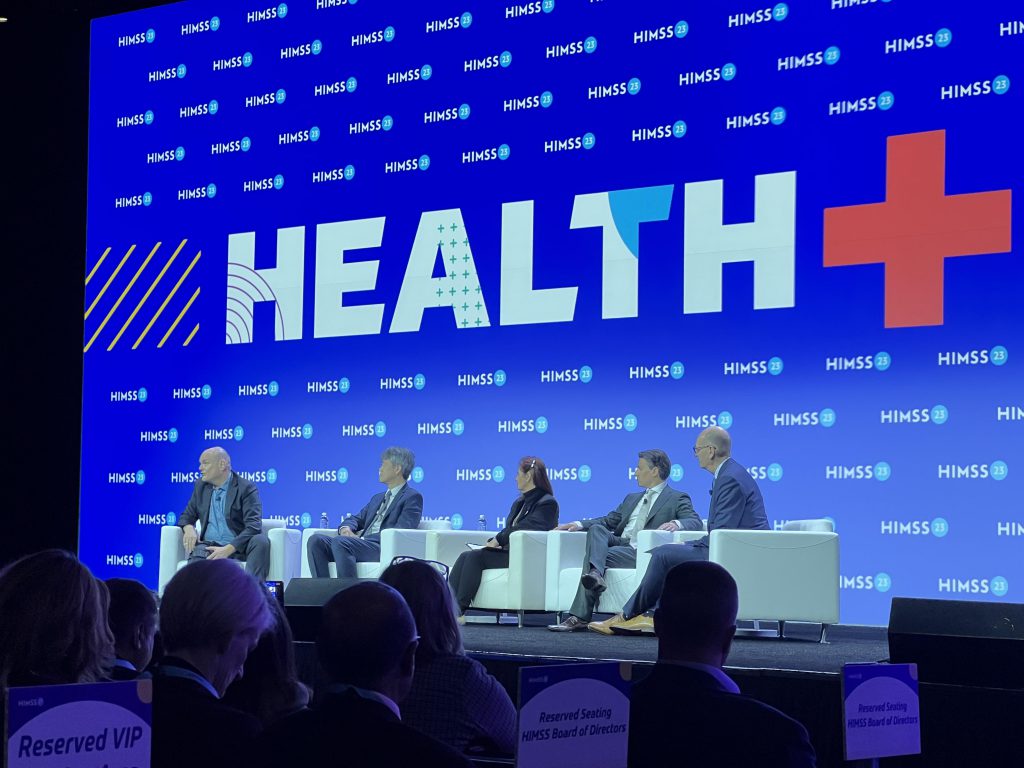

当地时间4月18日,HIMSS23在芝加哥拉开帷幕。开幕式现场座无虚席,来自世界各地的观众现场聆听了开幕主题演讲。由ChatGPT引爆的人工智能话题,在这一全球性医疗IT盛会同样备受关注。

HIMSS首席执行官哈尔·沃尔夫(Hal Wolf)宣布,该组织的成员现已超过12.2万人,在过去五年增加了60%,呈现全球化趋势。本次大会观众来自80多个国家的医疗保健和技术领导者,他们都在努力应对相似的挑战。

“在过去的三年里,我们不得不面对很多问题。”沃尔夫说。除了疫情流行,美国和世界各地的医疗健康领域仍然存在各种挑战:人口老龄化、慢性病和服务可及性、财务压力、人员短缺以及护理服务的根本转变,例如消费主义的兴起以及向远程医疗和家庭护理的转变。为了解决这些挑战,“现在对可操作信息的需求比过去任何时候都强烈。”沃尔夫说。

这些巨大信息的管理需求,将越来越多地由快速发展的人工智能提供支撑——这是开幕式进行的首场小组讨论的主题。这场讨论气氛友好而又充满争议。

人工智能和机器学习可以“开辟新的视野,如果我们适当地使用它们”。沃尔夫说。对于最近围绕OpenAI的ChatGPT宣传浪潮,他开玩笑说,最近向AI模型提出了一个简单的问题:“如何解决全球医疗保健挑战?”在几秒钟内,ChatGPT返回了答案:这些挑战复杂而多方面,因此需要采取涉及多个利益相关者、战略和解决方案的综合方法。其中列出了改善可及性、预防保健投资、技术创新、解决健康差异和全球合作等首要建议。

作为这场讨论的主持人,梅奥诊所首席信息官克里斯·罗斯(Cris Ross)表示,医疗保健仅处于“创建和学习如何管理这些新兴人工智能工具”的早期阶段,目前还很难讨论清楚。

罗斯召集了题为“负责任的人工智能:优先考虑患者安全、隐私和道德”(Responsible AI: Prioritizing Patient Safety, Privacy, and Ethical Considerations)的圆桌讨论,四位人工智能创新者参与了这场小组讨论:安德鲁·摩尔,Lovelace AI创始人兼首席执行官;Kay Firth-Butterfield,可信技术中心首席执行官;微软研究和孵化副总裁Peter Lee;《道德机器》(Ethical Machines)一书的作者、美德(Virtue)的首席执行官里德·布莱克曼(Reid Blackman)。

他们都需要回答罗斯提出的关于人工智能的一个简单问题:“仅仅因为我们可以做一件事,我们就应该去做吗?”

“这并不简单,还有很多东西需要学习”

一直以来,罗斯在将他定义的“大人工智能”(Big AI)——“类似机器但是有着可以比医生更好地诊断疾病的大胆设想”,与“小人工智能”(Little AI)做比较,后者是“已经在提供倾听、写作、帮助的机器——并不可逆转地改变了人们的生活和工作方式”。这些人工智能工具已经在帮助他们的用户做“越来越大的事情”。正是通过Little AI的进步,Big AI才会出现。

这一切正在迅速发生。出于这个原因,摩尔认为,医疗行业现在应该张开双臂拥抱挑战。

尽管像ChatGPT这样的大型语言模型(LLM)的快速发展,可能会让一些人感到不可思议,但“我希望一家负责任的医院现在就应该使用大型语言模型”。他说,比如用于客户服务和呼叫中心自动化等任务。

“不要等着看下一次迭代会发生什么,”摩尔说,“现在就行动。”他坚信生成式人工智能的能力已经显现,并正在以可能使医疗保健受益的方式出现。

一些有用的场景已经非常明显:集成生成式人工智能以改善临床笔记。例如,美国电子病历系统领导者企业Epic本周与微软和Nuance宣布,合作开发了生成式AI;医学院部署这类工具以便让AI扮演患者的角色。

但“也有一些可怕的风险”,Peter Lee认为,“这并不简单,还有很多东西需要学习。”

为了管理这些风险,Peter Lee特别提醒,“医疗领域需要有能力做出决策——是否、何时以及如何使用这些人工智能技术。”

“这背后有巨大的机会,但也有风险,其中一些我们可能还不知道。”他说。因此,医疗行业需要全面驾驭人工智能工具的开发和部署方式,以及如何演变,要密切关注安全性、有效性和公平性。

布莱克曼表示,他仍然对太多人工智能模型的“黑匣子”感到担忧。如果这些工具要获得更多的普及,特别是在临床环境中,那么更高的透明度和可解释性是基本的必备条件。

布莱克曼说,ChatGPT 4可能非常有用,但它“没有给你理由”为什么它会给出这些答案。

有时,正如模型对沃尔夫问题的回答所证明的那样:答案是准确和真实的,但它们经常使用一种神秘而复杂的计算来达到,其效果可能感觉像“魔术”。布莱克曼说:“也许我们对魔法本身无可非议,但如果你正在做癌症诊断,我需要确切地知道原因。”

他说,LLM是“一个单词预测器,而不是一个审议者”。即使经过仔细检查,当了解到这些原因时,会发现它们并不是你真正得到诊断的原因。但最终医疗机构将需要认真思考“我们能做什么?我们是否可以使用黑匣子模型,即使它运行良好?”

“不要停下来等着看会发生什么”

对于Firth-Butterfield来说,她是一封公开信的2.6万名签署者之一,呼吁实验室暂停训练新的强大人工智能系统至少六个月。理由之一是,必须了解清楚一个关键的问题:不是模型如何得出答案,而是在哪里可用?

“虽然有1亿人使用ChatGPT,但还有30亿人无法访问互联网。”她说,她对人工智能的担忧,与健康公平、偏见和问责制等有很大关系。

“如果你打算使用生成人工智能,你将与这些系统共享哪些数据?以及当出现问题时,你会起诉谁?”她问道。

Peter Lee赞同“人工智能的问责”是世界需要严重关切并弄清楚的问题。它需要逐个行业开展研究,医疗和教育尤其值得关注。

正如布莱克曼所指出的,智能技术与“让人误以为它是智能的技术”之间存在差异。

人工智能正在发展,甚至比许多专家想象的都要快。问题是,“这些变革性但神秘的技术应该用在哪里,医疗行业应该把它用在哪里?”罗斯说。

事实上,“除了伦理之外,我们仍然有深刻的科学奥秘”,Peter Lee说。他多年来一直在努力解决人工智能的伦理问题。

“我们正在冲向未来,并且不计后果。”Firth-Butterfield警告,“我们必须反省,我们希望从这些工具中获得什么?”

Peter Lee重申,他希望医疗界共同努力,帮助回答这个问题,确保指导和护栏到位,需要各种利益相关者一起参与解决一些共性问题。

他承认,对于人工智能已经做了什么,以及它未来可能的能力,仍然存在很多恐惧、不确定性和怀疑。因此,他的建议是通过学习来对抗这种不确定性。“动手,尝试沉浸其中并理解。然后与社区的其他人合作。”

摩尔同意被动观察不是一种选择。“不要停下来等着看会发生什么,”他说。“让你自己的人建立模型。不要只依赖供应商。确保你参与其中,让你的员工了解正在发生的事情。”(文中现场照片由John Shen提供)

精彩不容错过!

【责任编辑:秦勉】

HIT专家网

HIT专家网

评论前必须登录!

注册